L’Intelligence artificielle (IA) s’est imposée sans bruit, puis partout : rédiger un texte, résumer un rapport, trouver une idée, se fait désormais en quelques secondes, au bureau comme sur le téléphone. Ce confort a un envers moins visible : chaque requête sollicite des centres de données, de l’électricité, de l’eau pour le refroidissement. Entre promesse de productivité et coût énergétique, c’est un équilibre à trouver entre la taille des modèles, l’efficacité du matériel, le mix énergétique, la sobriété d’usage.

Reste une question centrale : comment conserver les bénéfices… sans alourdir l’empreinte.

À l’échelle mondiale, ChatGPT traite environ 2,5 milliards de requêtes par jour. OpenAI fait état d’environ 800 millions d’utilisateurs actifs chaque semaine (après environ 700 millions en juillet et environ 18 milliards de messages hebdomadaires dans une étude de septembre 2025). En Europe, l’adoption progresse aussi côté entreprises : 13,5 % des sociétés de plus de 10 salariés utilisent déjà des technologies d’IA, et près de 41 % des grandes entreprises. En France, comme chez nos voisins, les usages grand public ont nettement augmenté en 2025, au travail comme à la maison.

Bref, l’IA est devenue un usage de masse.

IA et environnement, un défi à la croisée des transitions numérique et écologique

L’essor de l’intelligence artificielle et des technologies numériques s’accompagne d’une consommation énergétique croissante. Les centres de données, indispensables au fonctionnement des IA, sont particulièrement énergivores. Leur alimentation nécessite non seulement une quantité massive d’électricité, mais aussi des systèmes de refroidissement qui accentuent la demande en ressources.

Plus précisément, l’envol des IA génératives, telles que ChatGPT, accessible gratuitement depuis fin 2022, et leur usage croissant à des fins récréatives, amènent Morgan Stanley à estimer qu’en 2027, la consommation énergétique de ces technologies pourrait rivaliser avec celle d’un pays comme l’Espagne. Les bilans RSE publiés en 2024 par Google et Microsoft confirment cette tendance : leurs émissions de CO₂ ont fortement augmenté, avec +48 % entre 2019 et 2023 pour Google et +29,1 % sur la même période pour Microsoft. Selon ces géants du numérique, cette hausse s’explique par l’explosion des besoins en puissance de calcul et en IA, conséquence directe de la montée en puissance des modèles génératifs.

Cette consommation entraîne plusieurs impacts :

- Augmentation des émissions de gaz à effet de serre : bien que le numérique ne soit pas le secteur le plus polluant, sa part dans les émissions mondiales progresse rapidement. En effet, le secteur numérique est responsable d’environ 3 à 4% des émissions mondiales de gaz à effet de serre. Pour la France, il représente 2,5% de nos émissions nationales en consacrant près de 10% de notre électricité, soit l’équivalent de la consommation de plus de huit millions de foyers (étude de l’Ademe et de l’Arcep en 2023). À cela s’ajoutent les projections de l’Agence internationale de l’énergie (AIE), qui anticipent un doublement de la consommation électrique des centres de données d’ici 2026, par rapport au niveau de 2022.

- Pression sur les ressources naturelles : la fabrication des équipements (serveurs, puces, terminaux) mobilise des métaux rares et de l’eau, accentuant les tensions sur les écosystèmes.

- Effet rebond : l’amélioration des performances et la baisse des coûts incitent à multiplier les usages, ce qui annule une partie des gains d’efficacité énergétique.

À cela s’ajoute la croissance exponentielle des modèles d’IA, dont l’entraînement nécessite des puissances de calcul colossales. Selon certaines estimations, l’empreinte carbone d’un seul modèle de grande taille peut être équivalente à plusieurs centaines de vols transatlantiques !

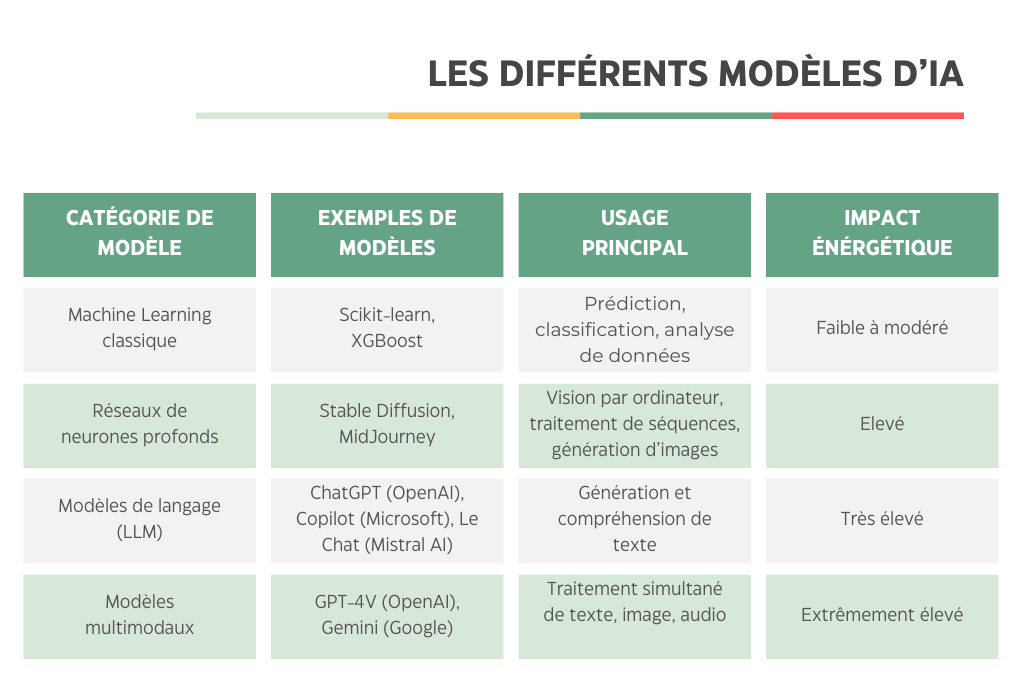

Les modèles de langage et modèles multimodaux sont les plus énergivores car ils nécessitent des milliards de paramètres et des ensembles de données massifs, impliquant des semaines d’entraînement sur des infrastructures très puissantes. A l’inverse, les modèles classiques restent relativement sobres, mais leur usage est limité à des tâches simples.

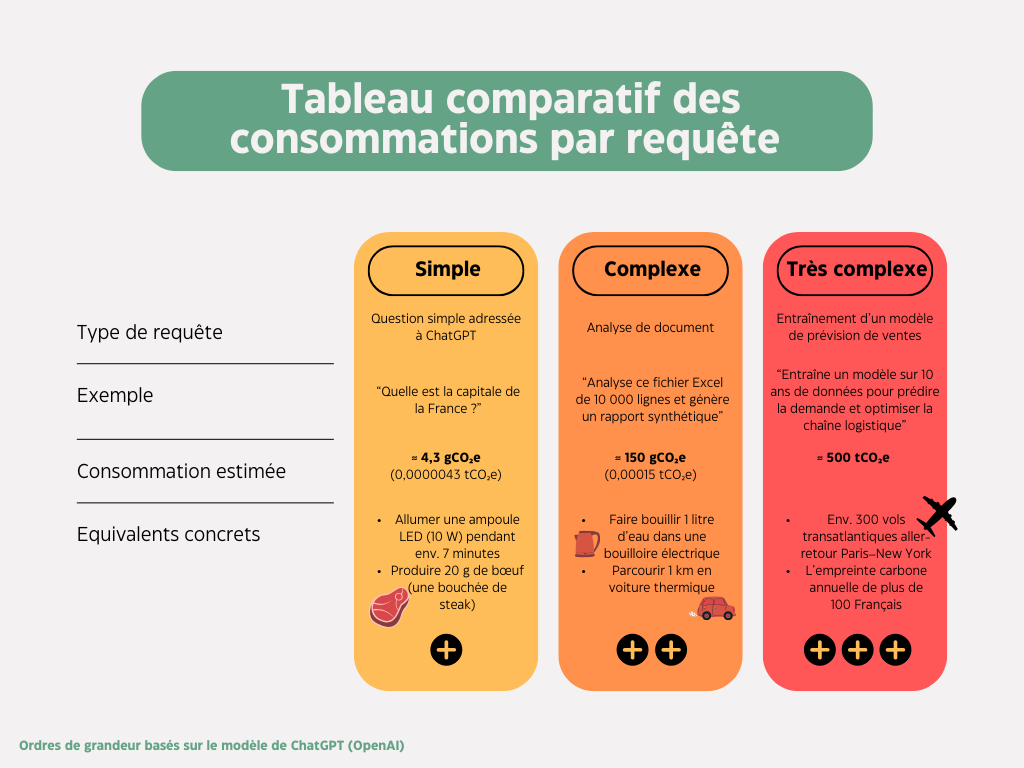

Pourquoi une telle différence des ordres de grandeur ?

- Une requête simple (quelques tokens) consomme très peu, mais l’effet cumulatif est énorme à l’échelle mondiale.

- Les requêtes complexes (analyse de documents, génération multimodale) peuvent être 10 à 30 fois plus énergivores.

- L’entraînement d’un modèle de prévision de ventes mobilise des milliers de GPU (unités de traitement graphique) pendant plusieurs semaines, ce qui représente une empreinte carbone colossale, sans commune mesure avec une requête utilisateur classique.